面对潜在的交通事故,无人车应该先救谁?

MIT认知科学家 Iyad Rahwan 在一封电子邮件中写道:“每次自动无人车进行复杂的行为活动时,都会潜在地对不同方面的风险进行权衡。”

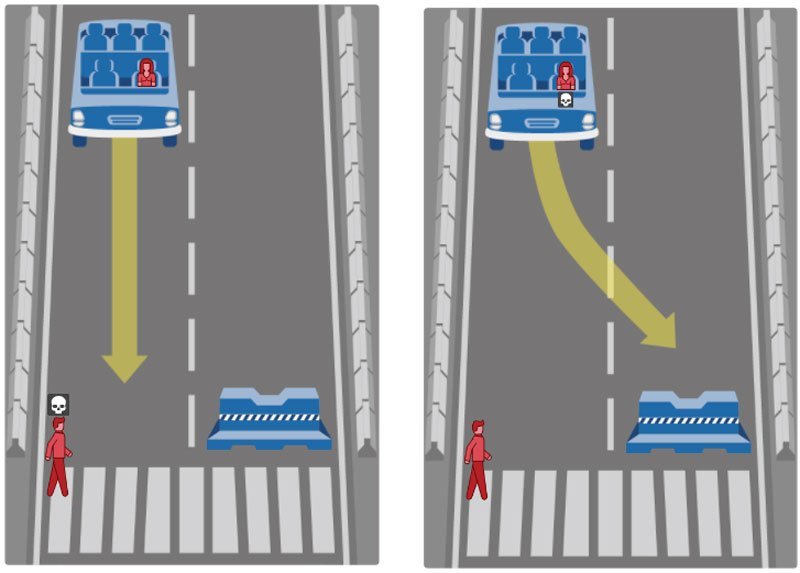

普通人在开车的时候,需要对周边的环境保持敏感,因为随着车辆的行驶,周边的一切事物就会被置于安全隐患之中。尽管驾驶员本身对自己的驾驶能力很自信,但不可否认,意外还是会在行车过程中发生。对于人类驾驶来说,人自身可以通过本能,对或大或小的事故作出道德判断和选择,但对于人工智能来说,一切就没那么容易了。在自动驾驶车辆(AV,autonomous vehicle)伦理道德方面有一个经典的议题:假如,一个人突然跑到了快速移动的无人车面前,汽车只有两条路可以选择,一条是转向旁边的路障,这样就会牺牲一车的乘客,另外一条路是直行,最终会导致这名行人牺牲。那么汽车究竟该如何选择?这是一个典型的“no-win”议题,虽然目前只是假想情况,但随着无人车越来越多,这样的道德难题必然会出现。

根据 Iyad Rahwan 的观点, 自动驾驶车辆程序员通常有两种选择,一种是为这些突发情况定义明确的规则,也就是说,控制无人车的算法可能有一套明确的道德权衡标准。比如,出现一只动物和出现一个行人,那么可能需要先牺牲动物的生命;另外一个选择,是在危机情况发生时,也可以通过不同软件的协同运行来做出决定。但无论哪种方式,目前都没有明确的计算程序能够妥善解决道德权衡问题,可能最终的解决方案也只能是依赖更完善的交通制度,希望对情况有所改善。

程序员不是哲学家,他们也只能模糊的对待这一议题,但从总体数据来看,危急情况下,无人车行为选择似乎有一套清晰可辨的模式可循——Oren Etzioni,AI2 公司 CEO 说,用 Harvey Cox (著名哈佛神学院教授,生于1929年)的话来说,不做决定就是一种决定。现在很多自动驾驶公司也只是选择不去正面面对这一问题。

道德选择问题的思考会变得越来越复杂。

据称,戴姆勒公司的执行官在今年秋天从中两难中做出了选择,会不遗余力保全车上乘客的生命。然而,公司方面却对此强烈反对,“很明显,程序员和自动化系统都不能被赋予权衡人类生命价值的权利”。其实,现在大多数公司对此还是采取不屑一顾的态度,戴姆勒就通过“实施风险躲避的经营战略”来避免直面这一问题。

与此同时,Google 比任何公司针对事故应激优化方面都公开了更多细节,这些细节具有明确的伦理倾向。 2014年时,Google X 创始人 Sebastian Thrun 表示,Google 的汽车在面临两个物体的时候,会选择撞击相对较小的一方。同样是在2014年,Google 一个横向车道专利(可能已经被采用,也可能没被采用)也使用了相同的逻辑,该专利解释了如果迎面驶过一辆卡车,汽车如何靠向另一车道的汽车,因为撞击小的物体更安全。

撞击小的物体——这同样也是伦理道德的问题。加州理工大学哲学教授 Patrick Lin 指出,这种方式只是通过最小化汽车撞击损失的方式来保护车上的乘客,但同时,也将危险转移到了行人,或者更小的车辆上的乘客身上。有时候,这一更小的物体很可能是一个婴儿车,或者小孩。

特斯拉已经在所有车上安装了全自动驾驶硬件。

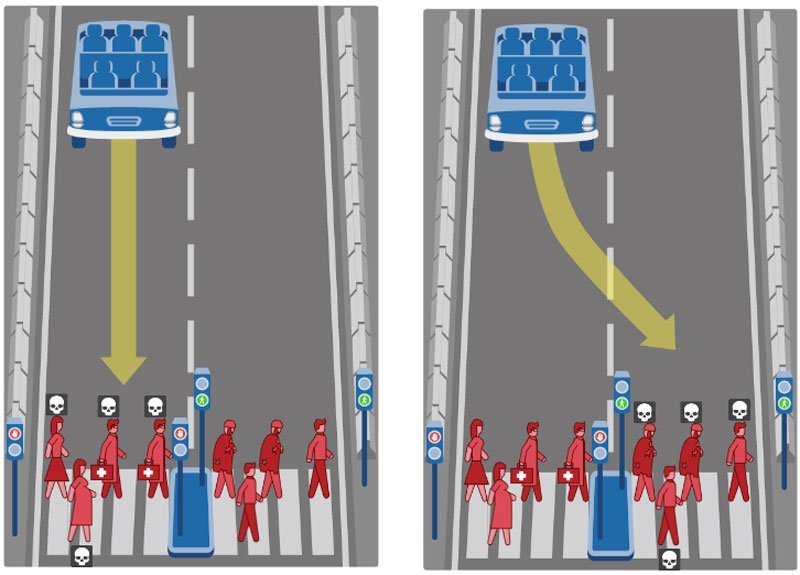

2016年3月,时任 Google 无人车负责人 Chris Urmson 描述了一个更为复杂的规则,无人车会首先尽全力避免撞击无保护的行人或者骑自行车的人,然后再努力避免撞击移动的东西。与之前撞击更小的物体相比,这种选择似乎更实用,他会尽全力保护有可能受到最大伤害的人,但是,对于购买者想要汽车最大程度上保护自己,那么这一规则可能就不那么受欢迎了。

美国国家公路交通安全管理局在今年9月的一份报告中指出,“制造商和其他实体机构,与监管机构和其他利益相关者(例如司机,乘客和不受保护的道路使用者,即行人)应该合作解决这一问题,以确保这些道德判断和决策确实是符合道德判断,和人性本能的。”

来自美国消费者保护协会的 Wayne Simpson 也表示,公众有权知道,当无人车在街道上行驶的时候,是以乘客、驾驶员,还是行人的生命安全为先,并且有权知道,有哪些因素决定了无人车最后的选择。如果公司无法给出没有漏洞的合理解释,那么应该限制汽车的功能,而不是单纯让其遵守社会规范、道德习惯与法律做出选择。Wayne 此处所指的就是苹果公司,而苹果公司也表示会“更深入的探索” 这一问题的解决方式。

Google 无人车 Waymo 很快就要面市。

此外,福特汽车也做出回应,已经开始和许多高校联合,针对无人车伦理道德问题建立产业合作关系。

但与此同时,福特公司也做出警示,不要过分限于哲学式的思考。全球汽车安全总监 Wayne Bahr 说,对这一问题的解答应该更多基于技术方面,而非不现实的哲学假设,因为这种哲学问题往往根本没有答案。在讨论高度无人车(HAV)相关问题时,一个普遍存在的问题就是,对于 HAV 的前提功能假设已经完全扭曲了,汽车并没有能力进行如此高级的价值判断,衡量哪个人的生命更重要。

Bahr 所指的,就是那些需要考虑到人群的年龄、法律地位、社会价值等等的价值衡量问题。至少短时间内, 无人车是没有能力辨别这些的。

从长期来说,现在主要的道德选择问题其实还是是否允许大批量无人车上路。目前,有数据显示无人驾驶可以减少90%的交通死伤,这一数字高于人类驾驶的交通死伤数量。而实现这一点,还需创建更好的法律制度,避免因失策而产生的争议或诉讼。换句话说,它依旧需要道德思考。

正如 MIT认知科学家Iyad Rahwan 以及同事 Azim Shariff 、Jean-François Bonnefon 在《纽约时报》的采访中所表示的:“越早使用无人驾驶汽车,越多的生命将会被挽留。如今繁琐、没什么用而又危险的驾驶体系人类已经忍耐了一个多实际,想要脱离这一切,仍然需要认真思索自动驾驶心理层面,以及技术层面的挑战。”

就像工业革命带来的变革一样,每一次先进科技的发展总是伴随着社会结构、产业结构的变化,未来,人-智能机器-机器协作与共存将成为人类社会结构的新常态,必将对人类社会产生具有跨时代的影响,人工智能的社会学研究,诸如劳务就业、社会结构变化、思维方式与观念的变化、心理上的威胁和技术失控危险等,这些都是值得高度关注的,影响社会安定和谐的社会问题。