动动嘴就能控制机器人!MIT新研究让机器人理解语境更懂你的话

编者按:本文来自微信公众号“量子位”(ID:QbitAI),编译:陈桦,36氪经授权发布。

科幻电影里的机器人早就能和人类无障碍沟通了,但在现实生活中,机器人理解自然语言的能力还非常差,稍微复杂一点的指令,就会让它们不知所措。

比如说:把我刚才放下的箱子拿起来。

让机器人明白这样的指令,是MIT计算机科学和人工智能实验室(CSAIL)最近才取得的突破。

MIT CSAIL设计出了一种方法,让机器人可以理解并响应以清晰明了的语言发出的语音指令。这个系统已经先进到可以理解涉及语境的指令,例如参考之前的命令和对象。

由CSAIL研究员开发的ComText(“语境中的指令”的缩写)系统提供了“类似Alexa”的机器人语音控制功能。这样的机器人可以理解语境,包括此前的指令,以及与之互动的对象和周围环境。

这意味着,用户可以像与他人互动一样与机器人互动。此前,与机器人的互动是个巨大的挑战,阻碍了机器人在商业场景和一般消费级场景中的应用。即使是在产业界,如果机器人可以理解自然语言语音指令,那么就可以更好地与人类合作。

通过对某些对象的理解,ComText可以用在工作中。例如,你可以告诉它,“我拿着的这个工具是我的工具”。未来,当你对它说“把我的工具拿给我”时,它就会找到正确的工具。

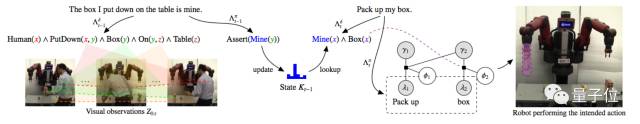

如上图所示,告诉机器人“我刚才放在桌子上的盒子是我的”,然后对它说“拿起我的盒子”,它就能正确理解。

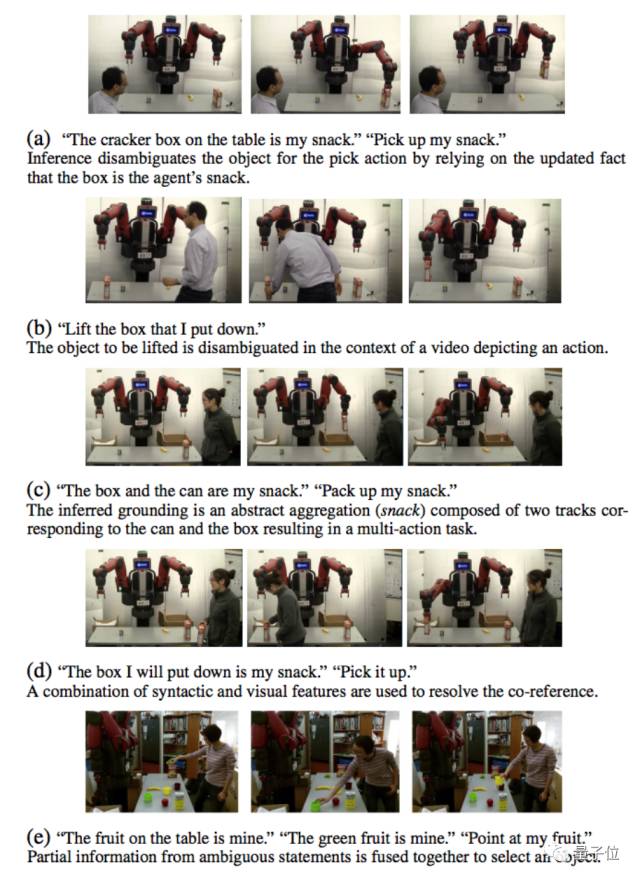

研究人员使用Baxter模型对ComText系统进行了检验。Baxter是Rethink Robotics开发的双臂人形机器人。

ComText在实现过程中采用了不同类型的记忆方式,包括用于一般信息的语义记忆,以及与特定事件关联在一起的情景记忆。

在测试过程中,机器人能在约90%的情况下对语音指令做出正确反应。研究团队希望通过更复杂的输入信息,包括多步指令,以及深化机器人对上下文信息的理解,提高正确响应的水平。

这项研究相关的论文Temporal Grounding Graphs for Language Understanding with Accrued Visual-Linguistic Context发表在刚刚结束的学术会议IJCAI 17上,作者包括MIT的Rohan Paul、Andrei Barbu、Sue Felshin、Boris Katz和Nicholas Roy。

地址:http://static.ijcai.org/proceedings-2017/0629.pdf