IBM 携手 MIT,要开发出像人一样表述所见所闻的 AI

由于计算能力的突飞猛进带动了机器学习的发展,近年来人工智能取得了不少突破。其中最显著的体现在语音识别、图像识别等方面,甚至连一些规则明确的游戏AI也已经战胜了人类的最高水平,比如在围棋项目上击败李世石的AlphaGo就是例子。但是人类仍然有一些不可撼动的优势,比如描述能力就是其中之一。看到一张图片,AI的确能识别出里面有两个人和一个足球,但是却无法说出“扑错方向的切赫绝望地目送梅西将皮球送入网窝”这样的话来,这让我们人类仍然拥有一丝自豪感。不过情况也许就要不同了,IBM正在跟MIT合作,试图在机器身上培养出这种能力。

IBM跟MIT联合成立的实验室叫做IBM-MIT脑启发多媒体机器理解实验室(IBM-MIT Laboratory for Brain-inspired Multimedia Machine Comprehension),该实验室的目的,是要通过数年的共同协作,寻求解决计算机视觉和听觉问题的解决方案。

该实验室由MIT大脑与认知科学系主任Jim DiCarlo领导,研究人员则来自该系以及MIT的CSAIL实验室,IBM的Watson团队也会有成员加入,他们希望这种组合能够碰撞出火花。其目标是研究出一套认知计算系统,这套系统应该能够像人一样,具备理解多来源的声音和视觉信息的能力,然后通过集成再将对世界的这种理解展示出来(而不是简单的二进制),从而提供医疗保健、教育以及娱乐等方面的用途。换句话说,就是像人一样表述看到和听到的东西。

按照这个目标,显然目前的图像识别功能还比较初级。AI可以用与人类相当的精确度识别出图像里面的对象,但光有这一点信息并没有太大的应用意义,图片和声音里面蕴含着丰富的上下文信息都被忽略了。而要想挖掘这些信息,就需要多学科交叉的配合,比如计算机视觉、语音识别、自然语言处理、模式识别、预测方法、决策技术、领域知识等。

为此,这个联合实验室将采用了无监督的机器学习对音视频流数据进行分析,并且按照大脑神经网络的组织对AI神经网络进行新的建模,通过多学科交叉来推进计算机的理解。而这种理解有很多的潜在应用,比如帮助老年人、残疾人改善生活,帮助组织维护和保养复杂机器等各种跨行业应用。

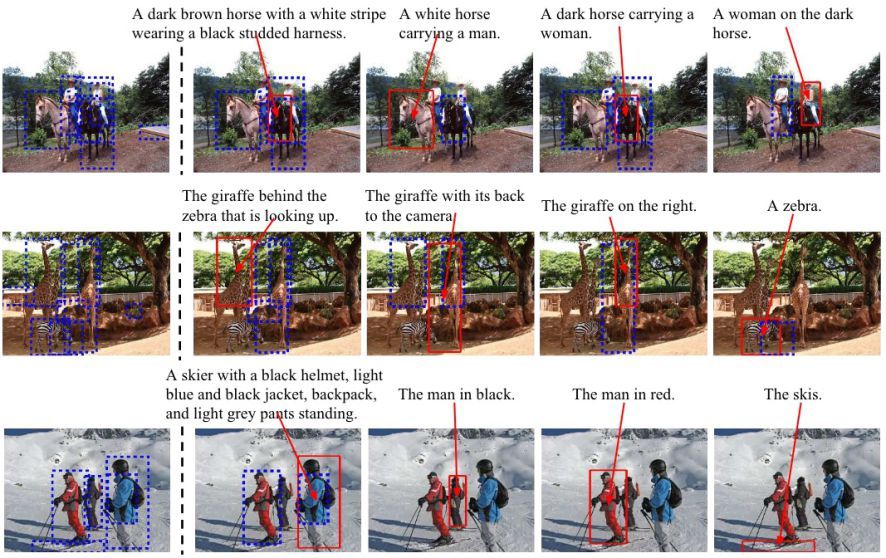

Google对这个方向也很感兴趣,而且已经有了一些初步的成果。如上图所示,它的AI现在不仅可以识别出图像的一些要素,而且还可以用类似自然语言的方式对场景进行表述了。比如说,“穿红衣服的人”,“背对镜头的长颈鹿”等,这种能力已经高于幼儿牙牙学语的水平。

与 Google 相比,IBM 在 AI 方面的努力也可谓过之而无不及。除了与MIT进行合作以外,IBM 还在决策支持、网络安全、语言深度学习等方面开展了协作,这些的共同基础是 IBM 的 Watson AI,IBM希望,通过多领域的协作,最终能够搭建出一个所谓的认知水平网络(Cognitive Horizons Network),到时候(也许是10年左右)也许我们就会看到一个超脑的雏形了。