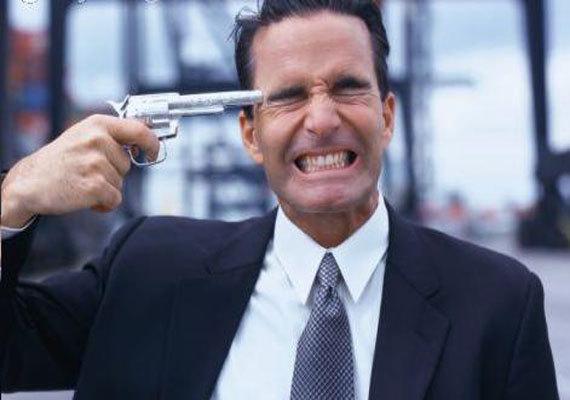

如何预知一个人是否有自杀倾向? 请把这项“救赎工作”交给AI |发现

作者| 廖垠雪

编辑| 傅博

在美国,自杀已经位居致人死亡原因名单上的第十。有时候,具有自杀念头的人可能会表现出一些自杀的倾向,比如一些不寻常的言行,这也许可以提醒他们的家人朋友,及时采取措施。

但是,在另一些情况下,企图自杀者几乎没有表现出任何想要自杀的倾向,这就让他们周围的人很难察觉,更不用说进行干预或阻止。

美国范德堡大学医学中心的数据科学家Colin Walsh最近正在开发一种机器学习算法,旨在预测个人尝试自杀的可能性。

他希望他的工作能够预测自杀风险,给这些已经心如死灰的人带来一点希望,至少给他们一个机会,问问“我该怎么办”。

目前,这项试验在预测一个人在未来两年是否会自杀这一点上,已经证实具有80%到90%的准确度。而在预测一个人在接下来的一个星期内是否有可能自杀时,它的准确度达到92%。

为了得出一个靠谱的预测结果,该算法使用一系列不同的数据,如被测试者以前的住院时间、年龄、性别、邮政编码、先前的诊断结果和使用过的药物等。

如果把所有这些数据结合起来,根据不同的风险因素就可以推导出关于被测试者行为的预测,而如果只是单独看其中一两个数据,就很难推导出明显的行为预测。

这个算法使用范德堡大学医学中心5167个具有自我伤害或自杀想法病患的数据进行了训练。在那之后,它又对12695名随机选择的患者进行了进一步的培训和测试,而这些患者没有企图自杀的历史。

这项测验在今年早些时候发布之后,Colin Walsh教授现在正在使用另一家医院的数据集来测试他的算法。在这个阶段的项目完成之后,下一个目标将是最关键的一个:

阐述如何利用它来干预并且拯救生命。

Walsh和他的团队惊奇地发现,服用褪黑激素似乎是计算自杀风险的一个重要因素。

“我不认为褪黑激素导致人们有自杀的想法,我们没有生理学相关的理论支撑。但有一件事对自杀风险至关重要,就是睡眠障碍。”

褪黑激素的相关用药可能会导致睡眠障碍,尽管这个假设目前尚未被证实。

这项研究还引发了一些关于伦理问题的讨论,比如计算机在医疗保健中所扮演的角色,以及如何使用个人信息。Walsh说:

“每项科学研究总是有意想不到的后果。 我们的意图是好的,想要建立一个帮助别人的系统,但有时也会出现一些意想不到的问题。”

研究人员还必须决定,基于计算机算法做出的决策和诊断将在多大程度上影响患者的护理。

作为一名专业的初级保健医生,Walsh表示,听从一台机器的命令,这是令人不安的。

会不会出现这样的情况,比如算法预测某个人具有高风险的自杀倾向,而这与我的临床诊断不一致?” “我是否会因为电脑告诉我的预测,就改变我的护理方法?”

目前,机器学习的算法是基于住院数据。但Walsh认识到,许多有自杀风险的人事先没有住院经历。

“我们生活中的大部分时间都是在医疗保健机构之外度过的。如果我们只依靠卫生保健机构中的数据来完成这项工作,那么我们的工作也仅仅局限在这一个方面。”

研究人员还能在哪里获得数据?互联网是一个不错的选择。Walsh说,他们花了很多时间在Facebook和Twitter上,在社交媒体上也许有数据可用于预测自杀风险。

“但是我们还需要做更多相关工作,来证实这是真的。”

用人工智能技术预测自杀风险的,Walsh既不是第一个,也不是最后一个。

早在今年1月,美国迈阿密的一名青少年在Facebook上直播自杀的过程,引起社会广泛关注。今年三月,Facebook宣布,他们正在使用人工智能,包括该公司的第一个模式识别算法,来审查发帖人的自我伤害的迹象。

公司表示,其新的人工智能项目首先会在有限的范围内推出,并且将采用机器学习来识别含有自杀想法的帖子,即使Facebook上没有人举报过这些帖子。

Facebook的发言人William Nevius说,机器学习算法将使用两个信号来进行判断是否有人处于自杀的危险之中,一个是用户帖子中与自杀或自我伤害相关的词语或短语,另一个是来自相关朋友的评论。

如果模式识别程序识别出了有关帖子,则“举报帖子”按钮会变得更加突出,从视觉上鼓励其他用户点击它。

如果这些信息显示事情已经处于紧急的状态,系统将自动提醒Facebook的社区运营团队 ——一组提供技术支持和监控网站的工作人员。

该小组将迅速审查相关的帖子,并确定这名用户是否需要额外的支持。如果的确如此,他们将确保该名用户将在ta的新闻版面看到一个弹出的页面,上面写有ta也许可以利用的一些资源,以阻止这名用户轻生(该页面通常只会在相关的朋友举报一个帖子时才会弹出。)

虽然目前的算法只限于对文字的识别,但Facebook最终也可能会使用人工智能识别包含自残或自杀倾向内容的照片和视频。

首席执行官马克·扎克伯格上个月宣布,作为评估举报内容(包括自杀,欺凌和骚扰)的一部分,该公司一直在“研究可以查看照片和视频的系统来标记我们的团队应该审核的内容”。

但训练机器来识别自杀的信号并不简单。

为了预测和干预措施的顺利进行,Walsh认为,人们必须公开谈论自杀这件事。 “如果我们因为感到不适就不去谈论这个话题,我们永远没法帮助别人,”他说。

自杀导致全世界每年死亡80万人,这是一个不容忽视的公共卫生问题。鉴于大多数人,包括医生,都不擅长识别自杀风险,机器学习也许可以提供有效的解决办法。

但是,自杀是一种非常强烈的个人行为,从人的角度来看,似乎不可能基于粗糙的数据来做出这样准确的预测。对于一个如此敏感的问题,仍然需要技术与人心通力合作,正面对抗人们的心魔。