很遗憾,AI还不能审查出儿童性侵录像:沙漠也被当成小黄片

编者按:本文来自微信公众号“量子位”(ID:QbitAI),Root 编译自 Gizmodo,36氪经授权发布。

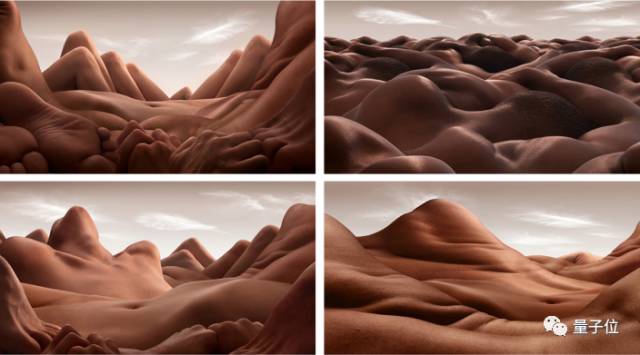

伦敦大都市警方希望两到三年内,能有AI算法可以识别录像中孩子是否被性侵,以及审查录像是否为儿童色情作品。不过目前来说,这套系统还不能判断裸露的身体和光秃秃的沙漠之间的区别。

警方现在已经开始使用图像识别算法,从电子监控录像中,甄别出犯罪行为,或与犯罪相关的物品,比如毒品、强制和大量成捆的现金。但对于裸体来说,现有的AI算法的判断结果还不够可靠。

“有些时候,给系统看沙漠组图,系统会认为是小黄片。”数字法医部部门主任Mark Stokes对电讯报说。“由于某种原因,很多人会用沙漠做屏保,然后我们的系统就以为这些人在看片。因为沙漠和皮肤的颜色太相近了。”

从手机或电脑上排查儿童色情作品工作量很大,做内容审查的人只能人工地看一个又一个的录像,工作内容特别乏味,精神上非常容易崩溃。

所以警方为了减轻人类的工作负担,想让没有情绪困扰的机器去做这方面工作。不过现阶段系统暂时靠不住,依靠系统标注和储存这部分敏感信息会让民众感到很不安心。

Stoke告诉电讯报,现在警方配合硅谷的工程师一起训练AI识别这些性侵儿童的图像资料。不过我们发现,即使是世界上最顶尖的科学家,训练所得的算法不仅不能保证每次都不出错,还会推荐会引发危险的错误信息,比如教唆种族歧视,两性方面的内容。

前一段时间有出过一款软件Nude,可以自动标记你相册里面的不可描述的照片,并放在一个加密的文件夹里,从iCloud上或者相册里出看不到的,这样可以保护手机用户的隐私。不过经过Gizmodo测试,这个App的算法还是会分不太清楚哪些照片才是不可描述的。

所以当人类去看系统处理的结果时,觉得不尽如人意。

比如说去年,脸书上有一张获得了普利策奖的照片,一个裸奔的小女孩从越南战场上逃离汽油袭击。

脸书的检测算法就自动把所有脸书上传播的相关照片都删掉了。后来官方恢复了这些照片,并承认了这些并不属于儿童色情作品。

计算机始终无法真正理解人类对裸体的定义。警方的软件也没有办法区分胴体和裸露的山丘。就像脸书的检测算法无法理解照片的背景内容。

△ 嗯,分不出来也不能怪算法

即使区分出来了,这些录像也很难找到安全系数足够高的数据中心存放。根据Stokes的说法,比起他们本地的数据中心来说,还是会考虑把标记好的录像放在亚马逊、谷歌、微软提供的云数据中心上。否则,审查不通过的内容一旦泄露,后果非常严重。