x86反击战再继续,“蓝色巨人”推专为AI设计的POWER9

“ 十年前客户在选型时会选RISC芯片的设备,五年前会考虑x86,但人工智能时代客户的决策重心已经在改变,是应用驱动,决策开始前移,会在一开始考虑到这套系统需要更多的CPU等。” IBM副总裁大中华区硬件系统部总经理侯淼如是告诉36氪。

这种不易察觉的变化,使得稳定持久的服务器芯片行业开始发生变革。现在,作为人工智能领域的重要玩家之一,蓝色巨人IBM正带着自己潜心研发四年的AI芯片架构POWER 9回归,加速这种客户购买行为改变。

在x86不断成熟的今天,这一次,IBM能以性能反击成功么?

一

服务器市场,X86与IBM POWER的爱恨情仇总是绕不开的话题。

面对已经占据服务器市场90%以上份额的x86,四年前,IBM出售x86服务器业务,聚焦高端市场。

四年之后,服务器市场开始迎来新的大变量——人工智能。AI重塑产业链的当下,包括数据中心业务在内的全产业决策的重心也在改变:软件开始定义硬件,需求开始定义产品。

侯淼发现,“今天的决策是应用结果来驱动决策的,很多客户开始做一个系统,比如人脸识别系统、钢厂残次品诊断系统,决策时会先思考哪些平台可以帮助实现这个目标。虽然与此前一样都是应用驱动,但是以前决策开始前移,会在一开始考虑到这套系统需要更多的CPU等。”

得益于互联网时代我们累积的巨量数据,AI技术的爆炸式进展,尤其是深度学习技术成熟被广泛应用,数据的计算开始成为瓶颈。众所周知,深度学习的过程可以简化理解为利用大量标注的图像进行训练,训练出一个行之有效的模型,再将这一模型运用新的图像的推断。这个耳熟能详的爆款算法是建立在多层大规模神经网络之上的,后者本质上是包含了矩阵乘积和卷积操作的大运算量函数。具体到训练,你需要先定义一个包含回归问题的方差、分类时的交叉熵的代价函数,再数据分批传递进网络,根据参数求导出代价函数值,从而更新整个网络模型。这通常意味着至少几百万次的相乘处理,计算量巨大,处理速度很有可能受到影响。

如何提升矩阵运算和卷积运算的处理效率,是解决算力难题的一把钥匙,这就是所谓的深度学习算法加速。使用GPU等进行硬件加速是当前最为常见的方法。NVIDIA股票高歌猛进的背后,是GPU在深度学习领域的作用也逐渐被认可。GPU最初被设计为能够执行并行指令,采用了大量的执行单元,这些执行单元可以轻松的加载并行处理,而无需CPU那样的单线程处理。

GPU解决了高维数据的运算问题,例如对诸如1000000x1000000或者更大规模的矩阵做乘法或者求逆。但是在企业通过购买很强大、晶体管更多的GPU解决了纯数据运算力的问题之后,海量数据的传输反而成为了应用程序的瓶颈。

CPU如同计算系统的大脑,而GPU则像是吃掉数据的猛兽,当我们无法调度CPU喂饱这只猛兽时,程序的速度就会出现瓶颈,而这种瓶颈很难简单通过加两块GPU或者CPU去简单的解决,甚至有时候盲目添加性能会造成性能没有显著提升但功耗却飞速增长。

而这正是POWER9想要解决的一大难题。

二

面对这样的契机,IBM也带着四年前启动的POWER 9芯片架构开始反扑日益壮大的x86市场。

IBM大中华区科技合作部副总裁 Mary Coucher告诉36氪,“ POWER9是针对目前人工智能时代而设计的产品,IBM在设计这个产品的整个过程中都是考虑到AI” 。

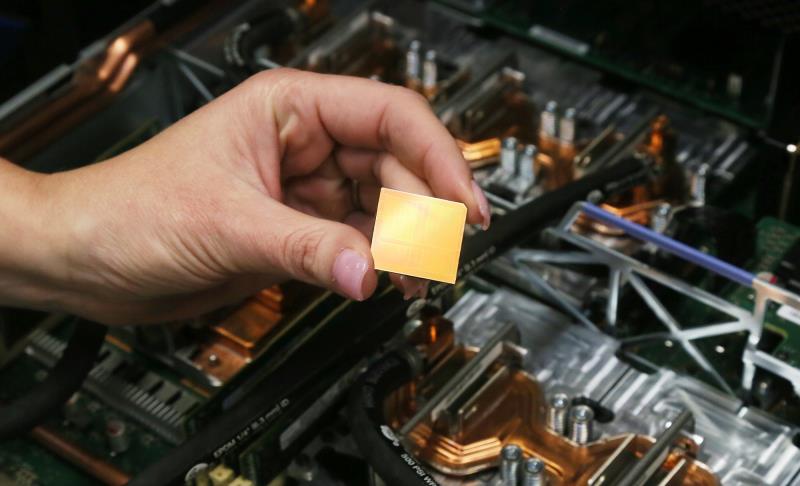

2016年HotChips大会上,IBM对外透露了诸多POWER9芯片的相关信息:14nm FinFET SOI工艺制成,逻辑线程总数最多都是96个,支持新一代CPU/GPU互连总线NVLink 2.0。这款耗时四年打造的芯片,被称为“ 专为人工智能设计”的芯片,开始向外界传达即将问世的信息,备受瞩目。

最新的数据显示,全新Power Systems深度学习框架性能超过x86近4倍,可将深度学习框架的训练时间加快近4倍,而基于全新POWER9的AC922 Power Systems, 在加速数据传送速度方面超出基于PCI-E 3.0的x86系统9.5倍。

这一效果的实现,有赖于PCI-E 4.0、CAPI2.0、新一代 NVLink及OpenCAPI等技术支持下的超高速数据传输的能力。

具体来说,要让计算机处理相关数据,往往需要从硬盘等存储介质中读取数据,或者将这些数据写入某些存储介质中,实现该功能的即是PCIE。相比于当前主流的PCI-E 3.0,PCI-E4.0不仅在低功耗、实时性、虚拟化方面做了增强,更在带宽上实现了翻倍,达到了16GT/s。

CPU与GPU之间数据的传输涉及到协议,CAPI就是帮助二者进行快速传输的协议之一。相比于CAPI1.0, CAPI2.0可以实现与CPU的总线加速通讯。而OpenCAPI目的是提供开放I/O加速标准来满足未来用户级加速器和I/O加速设备之需求。数据显示,OpenCAPI可以实现单通道每秒25Gbits的数据速率,性能超出了现有的PCIe规范,后者最高可以达到单通道每秒16Gbits的数据传输速率。

更值得一提的是NVLink技术。NVLink可以依据不同需求完成GPU-GPU节点内部的高速互联,同时还能在GPU-CPU之间形成高速互联。而新一代NVLink的性能比早一代NVLink的性能要高近一倍,同时GPU本身提供连接的、互联的通道也比原来要多,点与点之间通信带宽大幅提升至100GB/s到 150GB/s。

几种技术的叠加,意味着Power 系统中的数据,无论是在CPU- GPU之间传输还是GPU-GPU之间传输效率都有大幅度效率提升。而传统的x86服务器,数据传输的提升受到PCI-E 3.0 I/O能力的限制,Intel也很难给你提供一套完整的特殊的超高速数据传输方案。

此外,Power是一款典型的SMP架构处理器。顾名思义,对称架构处理器之间是平等工作的,它们共享一块内存(RAM),而Power的深度学习系统更进一步,让CPU们和GPU们能够访问一块内存,而不再有x86系统中常见显存和内存的概念。这意味着系统可以处理一些原来GPU单独很难达到的高密度或者大规模的计算问题。以内存宽度为例,POWER8系统为200GB,但到了POWER9数据提升到306GB。当前,POWER9支持的内参密度还是1TB的容量,将来这一数据还可以更多。

换句话说,在核心数提升和运算力不够增加GPU的情况下,Power的系统运算力的增长要远远快于x86的服务器系统,而这对于云计算或者数据中心来说是一个巨大的优势,有效提高了数据中心的性能功耗比。

IBM当前最先进的Power System AC922做得更直接,直接将2个POWER CPU和6块Tesla GPU互联在一起,提供了一站式的解决方案,从常用的神经网络(AlexNet VGG等)训练结果来说,得益于数据传输速度的大幅提升。Power的神经网络训练时间大幅缩短。

目前每一个POWER9可支持24核CPU,AC922有32核、40核两个版本可选,同时可以支持最多6个NVIDIA Tesla V100的GPU,这是今天业界最高端的GPU。在一个2U的空间中,封装6个GPU,无疑是业内领先的能力,也是做AI平台最主要的能力所在。侯淼告诉36氪,这也正是美国能源部橡树岭国家实验室看重AC922的原因之一。

三

Power主打高端服务器市场,对于这些客户来说,部署人工智能应用不仅会看重部署的速度以及未来的可拓展性。而这正是POWER9的两大优势。

根据IBM官方的数据,全新POWER9系统专为计算密集型人工智能工作负载而设计,可将深度学习框架的训练时效提高近四倍。

商业市场,唯快不破。研发人工智能的应用,模型训练环节至关重要。大量的数据投喂给机器,更快的处理速度才有可能更快的验证想法、做出模型。举例来说,如果在人工智能网络里选错了超参(Hyper-parameter),做了几天才发现,就需要重新设计算法和网络;而加速计算的过程,在几小时内发现这样的问题,就意味着拖慢的研发周期大幅缩短。

这在POWER8时代就已经被验证。根据深科技的报道,2017 年 8 月 IBM 使用自行开发的 POWER8服务器,配合 256 块 GPU,处理来自 ImageNet-22K 数据库的 750 万张图片时,不仅识别准确率高达 33.8%,高于微软2016 年创下的 29.8% 纪录,更将周期缩减到7小时,而一年之前微软则花费了10天。

除了硬件本身,IBM也在软件层面加速这一过程。以深度学习做人工智能的算法应用为例,IBM通过Hyper-parameter Search(超参挑选)这样的软件工具,帮助用户在GPU里进行分组,同时跑几组数据,从而得出最优的参数。

另一方面,今天很多人工智能的应用,已经不仅仅是跑在一台机器上,往往需要多台机器的配合。而这也是一直以来Power服务器的优势所在。

相比于采用NUMA结构的x86,采用SMP的Power架构可以保障内存在访问任意一枚CPU时速度是一致的,不会像x86一样,出现访问自己部分的内存速度飞快,但访问其他部门的内存就速度就会大幅缩减。因此,也不会像x86一样,很少做到4路以上。软件方面,今年12月初,IBM发布了名为Deep Learning Impact的软件工具,利用大数据的技术,可以把人工智能的框架水平扩展到多台机器上去跑。

根据此前公开的信息,在Power架构的服务器上,增加GPU,性能几乎可以实现线性增长,而这在x86架构的GPU集群上则很难想象。

四

当前,服务器市场正在迎来“新时代”的变革期,大数据、人工智能等技术对于服务器的产品形态及市场正产生巨大的影响。

根据IDC的2017年Q3云服务器市场的数据,全球服务器市场销售额增长近20%,一反过去几个季度的缓慢增长,增长动力则是来自于Hyperscale(超大规模数据中心)和企业级市场的持续增长。

另一方面,随着AI市场的火热,以GPU和FPGA加速计算为主的异构计算取得了爆发式增长,也成为市场变革的重要动力,国内方面,包括浪潮、中科曙光在内的服务器厂商也纷纷推出相关产品;国外方面,芯片大厂Intel、AMD也都推出了新品芯片。

事实上,每一次技术的大迭代,都往往意味着行业的洗牌。

了解CPU处理器发展史的人都知道,IBM曾经有一款在小型机领域大获成功的RISC(精简指令集)CPU设计,也就是Power系列CPU,Power 系列的小型机通过其设计上的标准SMP架构(对称多处理器),和异常稳定的软件生态系统获得了不小的成功,尤其是在对可靠性要求的高端市场取得了很大的成功。

然而在新世纪云计算越来越成熟的大背景下,系统已经越来越不依靠几台小型机来保证运行效果。Intel x86越来越普及,ARM在嵌入式和低功耗领域通过IP模式占据了大部市场,而POWER系列的CPU由于高昂的价格很难得到应用,以至于近年来POWER CPU退出历史舞台的声音越来越多。

作为1956年的达特茅斯会议的参与方,IBM是最早开始涉足人工智能的科技公司,也在人工智能和认知计算领域有着多年的研究和积累。与当前诸多被打上人工智能公司标签的科技巨头相比,IBM较早就完成了硬件、软件、算法、应用的全产业链布局。作为一家企业服务的公司,IBM也是少数有大规模部署人工智能应用的公司之一。

当这场服务器竞赛的天平,开始偏向IBM更为擅长的领域,性能领先的POWER,又会交出一份怎样的答卷?