激光雷达存废之争 | 自动驾驶汽车商业化能不能去掉它?

这本不是个值得讨论的话题,在此之前,自动驾驶领域旗帜鲜明的反激光雷达阵营公司寥寥无几,相反,挺激光雷达一派是绝对的主流。但随着自动驾驶技术的演进,摄像头在整个感知层的地位开始逐渐上升,我们不妨试着探讨一下,激光雷达存废之争。

车用激光雷达的诞生

毋庸置疑,激光雷达已经随着自动驾驶产业的繁荣变得炙手可热。以下是雷锋网·新智驾整理的全球激光雷达公司投融资现状一览。

图片来自雷锋网新智驾

可以看到,自动驾驶业者百度、福特、戴姆勒、德尔福、采埃孚、英特尔均有所布局。除此之外,谷歌Waymo去年2月宣布将激光雷达的成本降低了90%以上;通用汽车去年10月宣布收购激光雷达创业公司Strobe,据称后者技术可将激光雷达成本降低99%;激光雷达巨头Velodyne的巨型工厂「Megafactory」的新产线已经投产,预计产能将达到100万台/年。

那么激光雷达是如何被发现并用于自动驾驶汽车的呢?在回答这个问题前,我们先来讲一下当下自动驾驶感知层的三大技术流派,括号内为该企业研发自动驾驶技术元年:

Google(2009)、百度(2013):激光雷达为主

苹果(2016)、Uber(2015)、Roadstar(2016):多传感器融合

特斯拉(AP2.0:2016)、驭势科技(2016)、Auto X(2016):摄像头为主

这一波自动驾驶浪潮最早要追溯到2009年谷歌Google X实验室启动的自动驾驶项目。Sebastian Thrun教授是Google X实验室创始人,也被认为是谷歌无人车之父。在加入谷歌前,他领导的斯坦福大学自动驾驶团队曾在美国国防高级研究计划局(DARPA)发起的2005 年第二届自动驾驶挑战赛中夺冠。Google X自动驾驶项目曾收编了大量斯坦福自动驾驶团队成员,这支团队将以激光雷达为主、摄像头+其他传感器为辅的感知技术路线带到了Google。

激光雷达的感知精度要高于摄像头,可以记录下比摄像头更丰富的细节,所以在当时被视为自动驾驶感知环节的核心传感器,但这一技术路线有着明显的历史局限性。事实上,当时的计算机算力不够,尤其是计算机视觉、深度学习尚未取得进展,这些原因限制了从业者对于摄像头性能表现的想象力。

自动驾驶创业公司Auto X创始人肖建雄表示,不论是过去还是现在,整个自动驾驶汽车业界都是由机器人专家在主导,他们往往专注于开发可靠的单个零部件,并将它们组合在一起进行工程设计。所以谷歌百度们采取了「重感知轻计算」的技术路线,通过的激光雷达更高的可靠性与精度来简化后续的计算任务及决策压力。

摄像头VS激光雷达,其实是计算机视觉专家VS机器人学家之争

那么,有了近两年计算机视觉、AI和芯片领域的发展加持,摄像头的性能极限能到什么水平?

反激光雷达阵营立场最鲜明的就是最近盘踞在各大科技媒体头条的特斯拉CEO Elon Musk,他对激光雷达之于自动驾驶汽车的最新评价是「昂贵、丑陋和不必要」。前两条随着前面巨头的资本投入和技术人才的改进都会得到解决,但「不必要」直接动摇了激光雷达存在的根基。

下面是他给出的观点:

显而易见,道路系统是面向被动光学的。为了在任何给定/变化的环境中(实现车辆自动)驾驶,我们必须把被动光学图像识别问题解决得非常好。当你把这个问题搞定,主动光学器件(激光雷达)存在的意义是什么?它不能读取路标,在我看来,它就像是拐杖,会让那些公司陷入非常难以摆脱的境地。

如果你坚持极为复杂的神经网络技术路线,做到了非常先进的图像识别技术,那么我认为你最大化的解决了问题。然后你需要把它和日趋复杂的雷达信息融合,如果你选择了波长在400纳米-700纳米的范围内的主动质子发生器,其实是很愚蠢的,因为你被动的做到了这一点。

你最终会尝试在大约4毫米的雷达频率上主动发出质子,因为(该频率)可以穿透障碍物,你可以透过雪、雨、灰尘、雾……其他任何东西“看”清前方路况。令人费解的是,一些公司会用错误的波长来做主动质子发生系统。它们给汽车武装了一大堆昂贵设备,让汽车变得昂贵、丑陋也不必要。我觉得它们最终会发现自己在竞争中陷入劣势。

非常诚恳的讲了一些基本物理原理,抛开吃瓜群众难懂的部分,可以提取到一个知识点:理论上讲,通过摄像头+复杂的算法实现感知是可行的,但算法部分的技术挑战很大。

特斯拉内部也一直在提升对AI领域的重视,一个有趣的信息点可以佐证:在Autopilot软件副总裁Chris Lattner离职后,领导Autopilot视觉组的继任者Andrej Karpathy的Title变成了特斯拉AI总监。

有没有人同意他的观点?有,驭势科技的杜勇博士同样认为,单纯地基于视觉来解决无人车的路况感知问题是可行的,但是还有很长的路要走,无人车的发展过程应该是一个视觉逐步替代高端激光雷达的过程。

为什么说摄像头比激光雷达更适合做主传感器?在实际驾驶过程中,驾驶员获取绝大部分信息均来自于视觉,比如车身四周的机动车、非机动车、行人、动物、道路标识、道路本身、车道线等,研究表明大约90%的环境信息均来自于视觉。

但算法挑战难就难在这里,摄像头需要识别和估算的目标繁多,导致基于目标监测与识别的学习算法变得十分复杂。所幸计算机视觉领域开始出现一些可喜的突破。

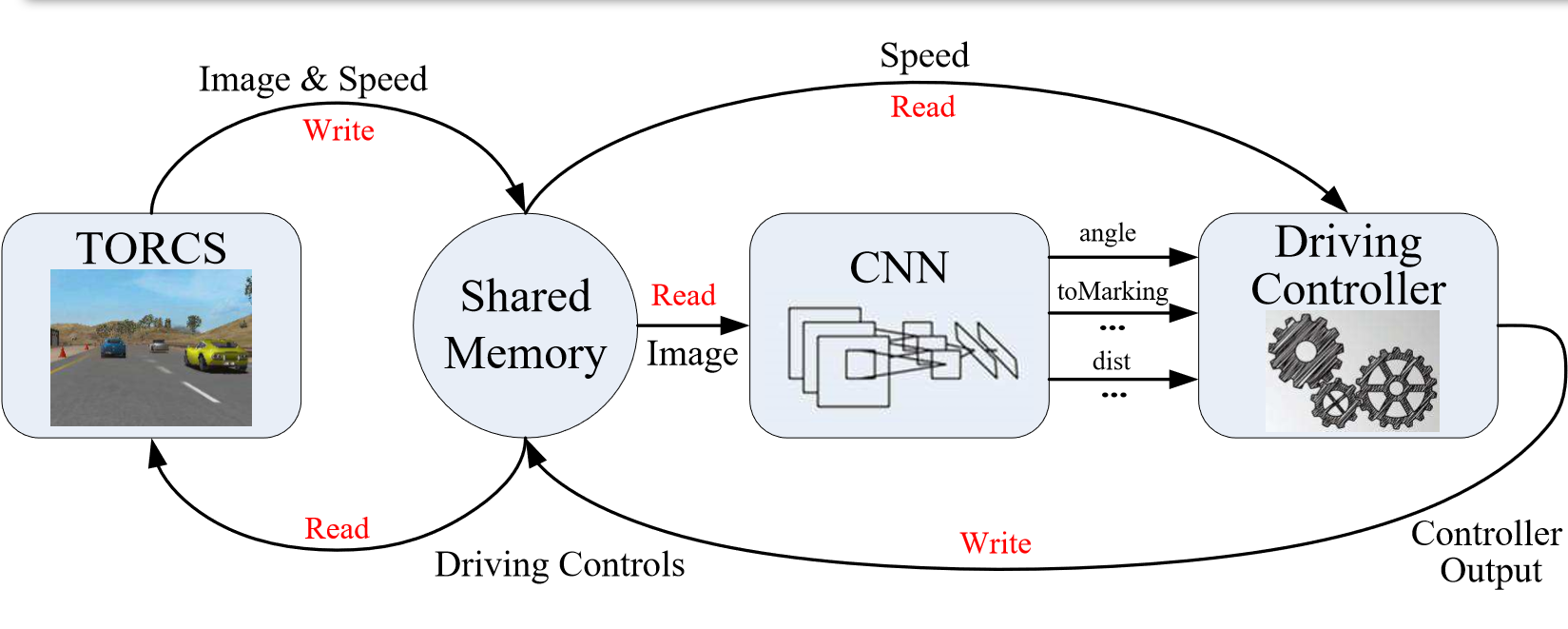

2015年的国际计算机视觉大会(ICCV)上,美国普林斯顿大学计算机视觉和机器人实验室团队公布了他们研究的深度学习算法,根据其论文《DeepDriving: Learning Affordance for Direct Perception in Autonomous Driving》中出现的算法架构,该团队通过深度卷积神经网络直接感知驾驶操控(driving affordance),在大幅简化算法复杂度的同时,大大提升了自动驾驶算法的鲁棒性,被视为自动驾驶技术上的一个重大突破。

这项研究的负责人,就是前面提到的Auto X创始人肖建雄博士。在代表普林斯顿大学去ICCV介绍他们的研究时,肖建雄的Title是普林斯顿大学助理教授、计算机视觉和机器人实验室创始人。近三年,肖建雄发起或参与了几乎所有关于三维深度学习的研究——参与发布目前最大的公共三维数据集(三维数据里的ImageNet)ModelNet和ShapeNet;创建了研究三维深度学习的基础网络框架Marvin,为后来者做了铺垫;推出3D卷积网络Deep Sliding Shapes ,在RGD-D图像中研究三维物体的特征……属于学而优则商的典型代表。

自动驾驶公司放出了各种各样的路测Demo,截至目前基于纯视觉方案的只有Auto X。肖建雄此前接受采访时反复提到的一个观点:「摄像头的潜力被低估了,理论上,摄像头可以做到比人眼还厉害。」要知道,哪怕是64线的激光雷达的有效监控范围很难超越前方200米,而人眼可以轻易发现前方几百米外的威胁。

除了特斯拉、Auto X和驭势,还有没有尝试视觉路线的大公司?Uber。下面这位就是Uber纯视觉技术路线负责人Raquel Urtasun。

Urtasun身后顶着64线激光雷达的Uber地图采集车与她推进的视觉路线有些违和

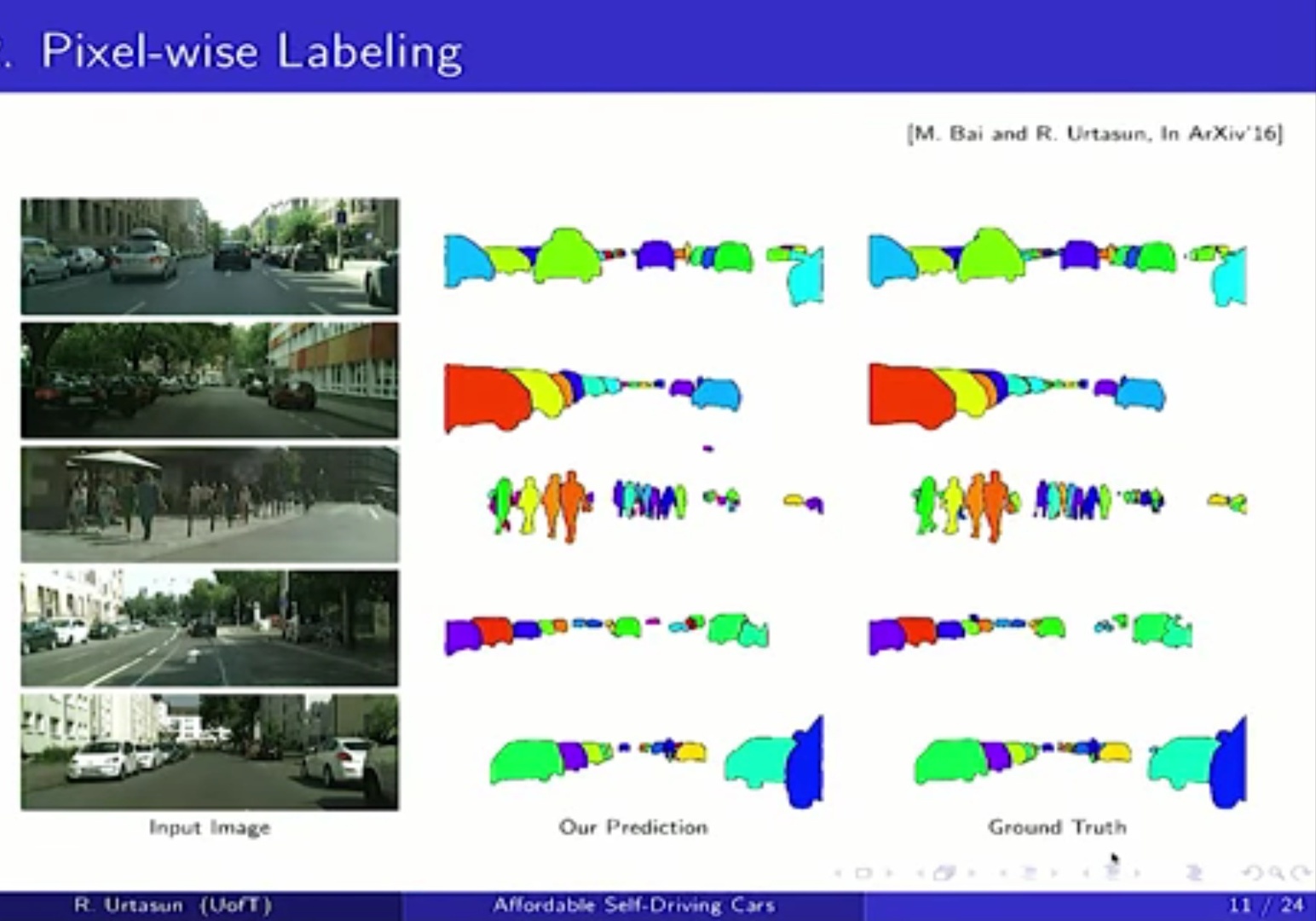

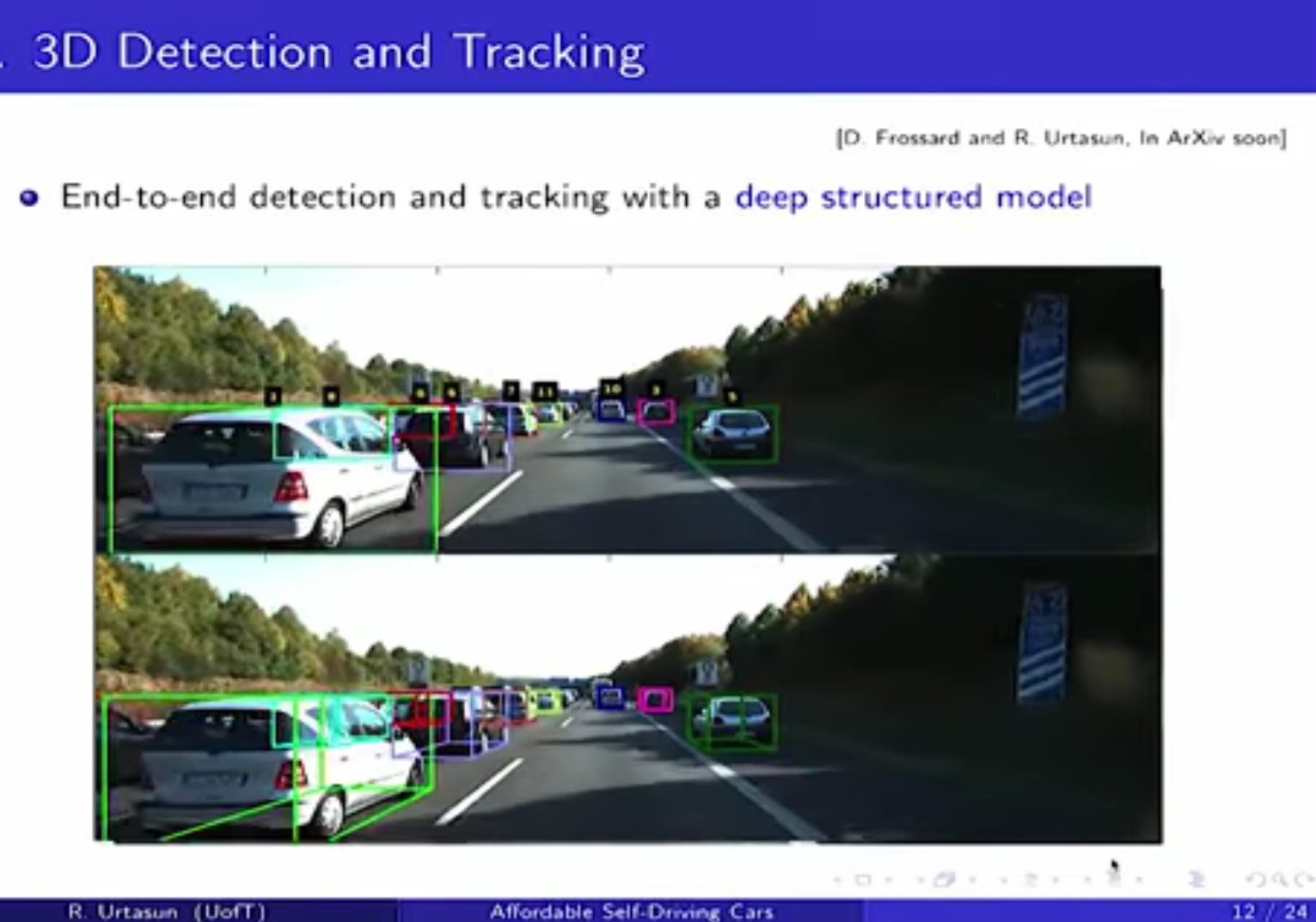

去年5月,也就是Uber先进技术集团(Advanced Technologies Group)与谷歌Waymo官司缠身的时候,Uber宣布在加拿大多伦多成立先进技术集团加拿大分部,Urtasun及其团队将专注于三个领域的研究:自动驾驶技术的环境感知及物体识别,汽车定位技术和高精度地图绘制技术。

彼时的评论认为,考虑到Uber与Waymo的诉讼战仍在持续,Uber这一举动有多方下注保存实力,避免正面冲突的意味。没有人意识到,Uber实际上开辟了一条全新的、基于视觉方案的自动驾驶技术路线。

Urtasun此前加拿大多伦多大学计算机科学领域的副教授、加拿大机器学习与计算机视觉研究会主席。加入Uber前,她已经花了多年时间尝试降低激光雷达在自动驾驶感知领域的重要性。她长期以来坚持的观点和肖建雄、Elon Musk并没有什么两样:如果不能摆脱激光雷达,自动驾驶汽车普及的希望很小。

作为“机器感知和人工智能领域全球最顶尖的研究人员之一”(前Uber CEO Travis Kalanick语),Urtasun通过研究发现,在某些情况下,车辆可以通过普通摄像头获得激光雷达数据的三维路况信息。加入Uber几周后,在纽约举行的一次计算机视觉会议上,Urtasun分享了她的团队用摄像头代替激光雷达的研究成果。,该系统可以实时运行,在40米范围内性能表现对标激光雷达。但这个范围明显低于高端激光雷达的支持范围,看来Urtasun的团队还要继续努力。

德国卡尔斯鲁厄街道的三维视图

Urtasun不看好激光雷达路线的另一个原因在于高精度地图,激光雷达决定的时间和成本从根本上阻碍了自动驾驶汽车的普及,所以基于视觉方案的「可扩展性」高精度地图绘制也是她的研究课题之一。

如果你长期关注自动驾驶领域,看到这里还会想到一个人:Mobileye CTO Amnon Shashua。虽然特斯拉和Mobileye分道扬镳了,不过在以摄像头为主的技术路线,研发自动驾驶ASIC芯片(Eye Q5)和高精度地图量产(REM架构)的经济性考量方面,这两家企业保持着惊人的一致,如今Urtasun领导的Uber ATG加拿大团队,算是壮大了这一阵营。

摄像头拥有最丰富的线性密度,其数据量远超其他类型的传感器。地平线自动驾驶商务总监李星宇提到,地平线曾与很多主机厂及大型 Tier 1 供应商进行沟通后得到的一致结论就是,基于视觉的感知在整个自动驾驶体系中的重要性正在持续提升。基于图像信息密度最高的优势,使得它处于整个感知融合的中心地位。

同时他也指出,视觉感知仍然有它的能力边界,多传感器的融合其实是商业化自动驾驶达到高可靠性的必由之路。事实上,毫米波雷达和超声波传感器的成本和性能已经支持商业化,所以终极问题还是,这里的“多传感器”中,有没有激光雷达的位置?

我是36氪汽车小组记者郑晓康,关注特斯拉、无人驾驶、新能源车、车联网、出行及后市场,欢迎直接与我联系,微信:15735104947